コンピューターで大規模言語モデル (LLM) を実行したい場合、最も簡単な方法の 1 つは Ollama を使用することです。Ollama は、カスタマイズ可能で簡単にアクセスできる AI エクスペリエンスを提供する強力なオープンソース プラットフォームです。クラウドベースのプラットフォームに頼ったり、技術的な専門知識を必要とせずに、さまざまな LLM を簡単にダウンロード、インストール、操作できます。

上記の利点に加えて、Ollama は非常に軽量で定期的に更新されるため、ローカル マシン上で LLM を構築および管理するのに非常に適しています。したがって、外部サーバーや複雑な構成は必要ありません。Ollama は、Windows、Linux、macOS などの複数のオペレーティング システムと、さまざまな Docker 環境もサポートしています。

Ollamaのダウンロードとインストール

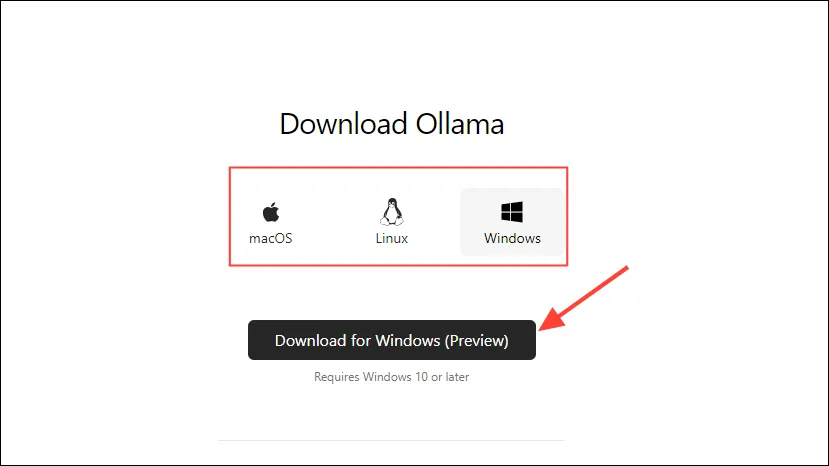

- まず、Ollama のダウンロード ページにアクセスし、OS を選択してから「ダウンロード」ボタンをクリックします。

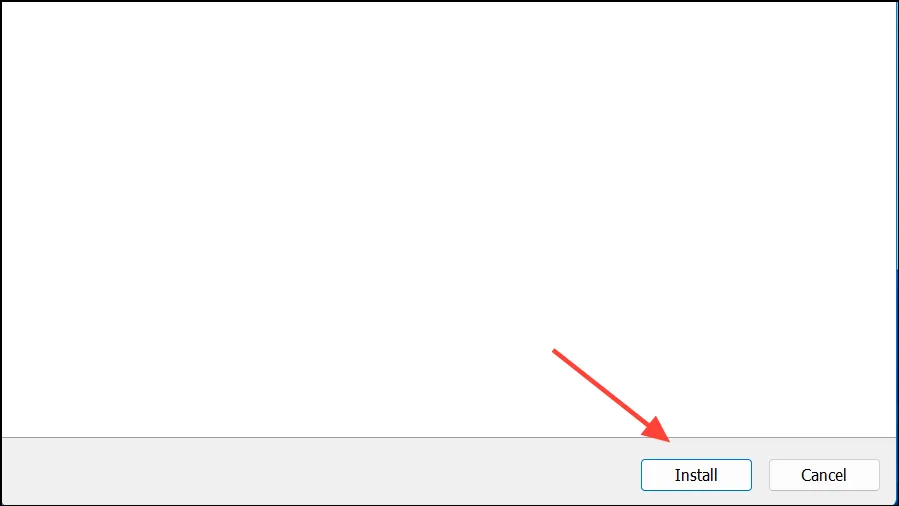

- ダウンロードが完了したら、それを開いてマシンにインストールします。インストールが完了すると、インストーラーは自動的に閉じます。

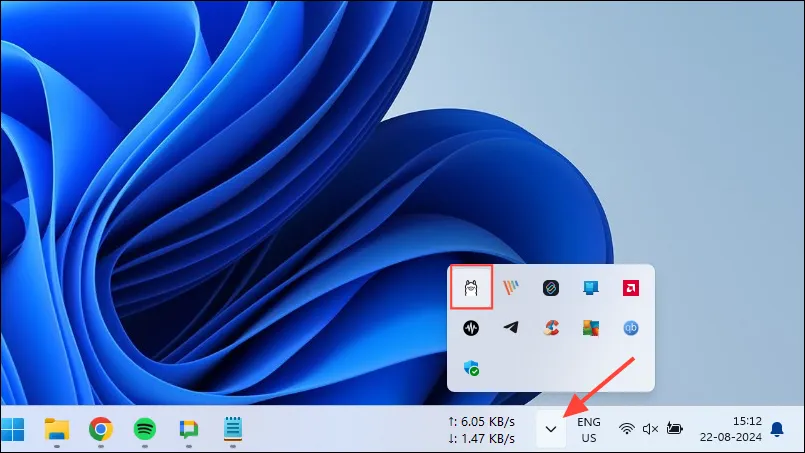

- Windows では、タスクバーのオーバーフロー ボタンをクリックして隠れたアイコンを表示することで、Ollama が実行中かどうかを確認できます。

Ollamaのカスタマイズと使用

Ollamaをコンピュータにインストールしたら、まずデータの保存場所を変更する必要があります。デフォルトでは、保存場所はですC:\Users\%username%\.ollama\modelsが、AIモデルは非常に大きいため、Cドライブがすぐにいっぱいになる可能性があります。これを行うには、

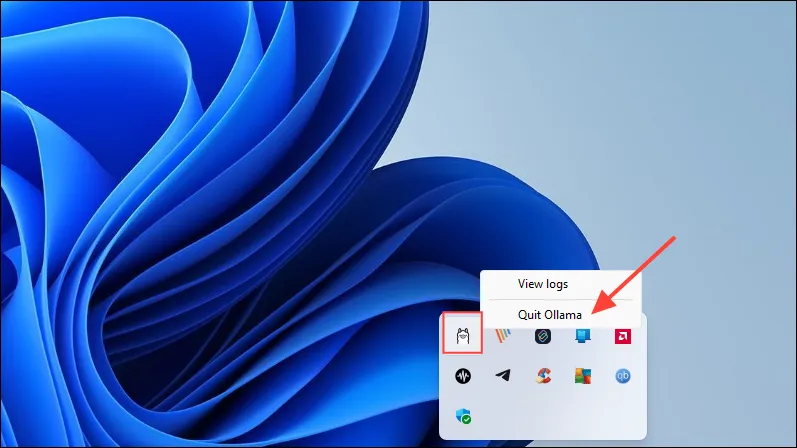

- まず、タスクバーの Ollama アイコンをクリックし、「Ollama を終了」をクリックします。

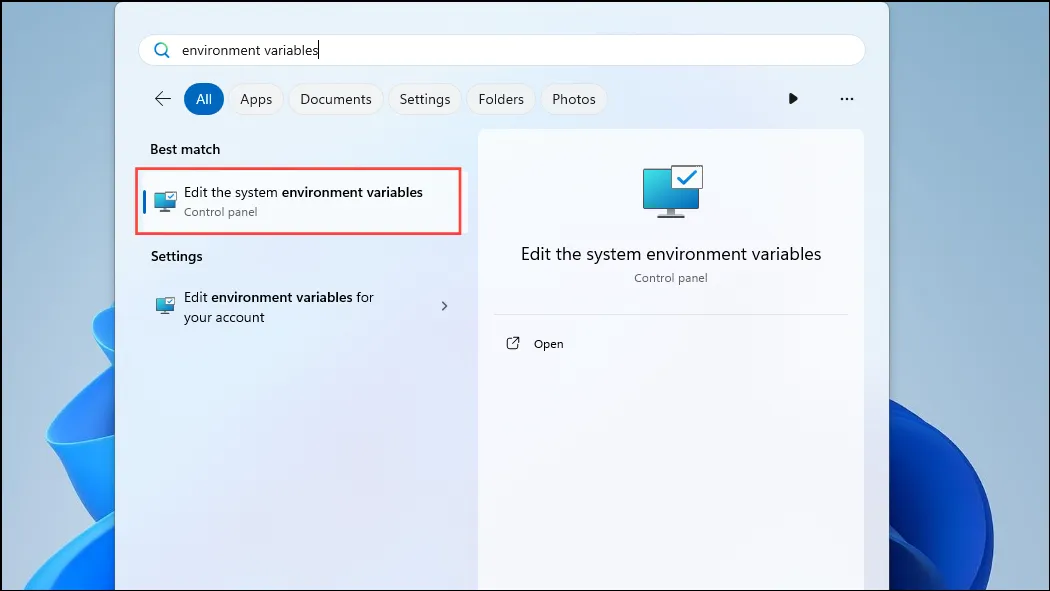

- Ollama が終了したら、[スタート] メニューを開き、

environment variables「システム環境変数の編集」と入力してクリックします。

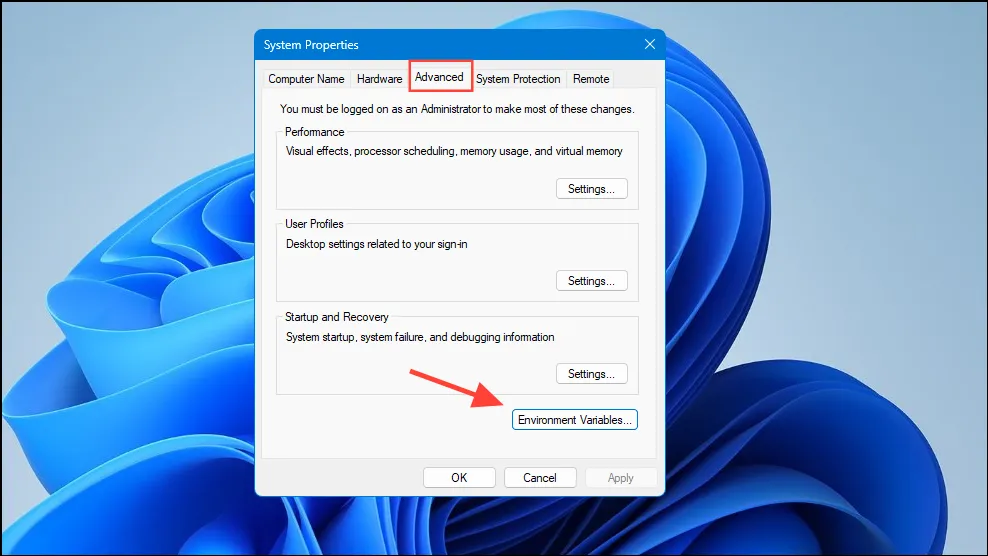

- 「システム変数」ダイアログボックスが開いたら、「詳細設定」タブの「環境変数」ボタンをクリックします。

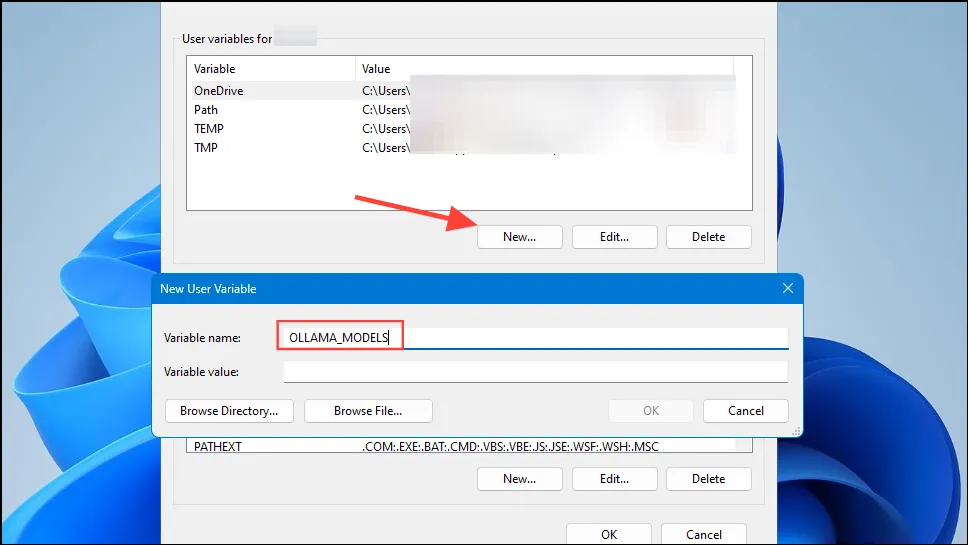

OLLAMA_MODELSユーザー アカウントの [新規] ボタンをクリックし、 [変数名] フィールドに名前を付けた変数を作成します。

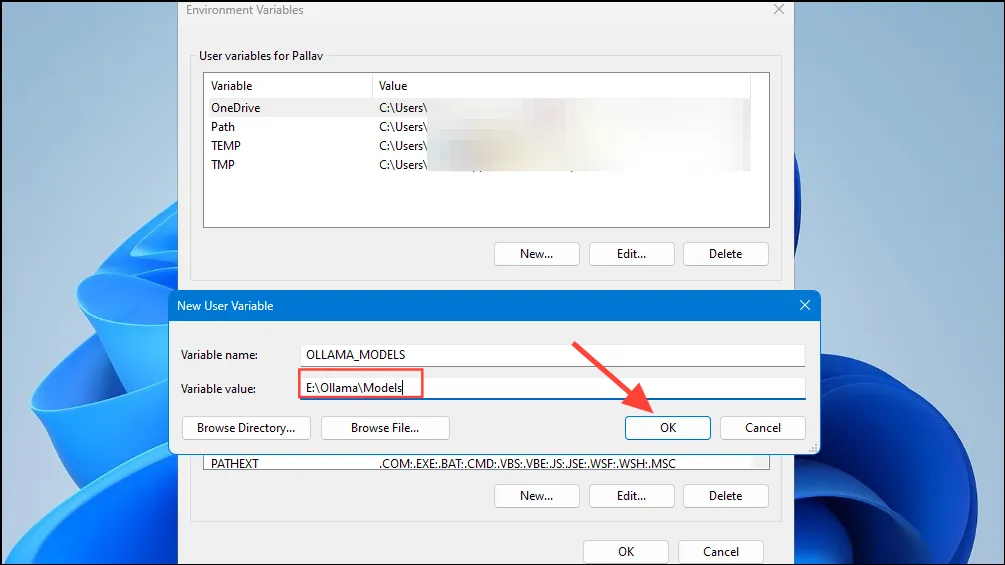

- 次に、Ollama がモデルを保存するディレクトリの場所を「変数値」フィールドに入力します。次に、「OK」ボタンをクリックしてから、スタート メニューから Ollama を起動します。

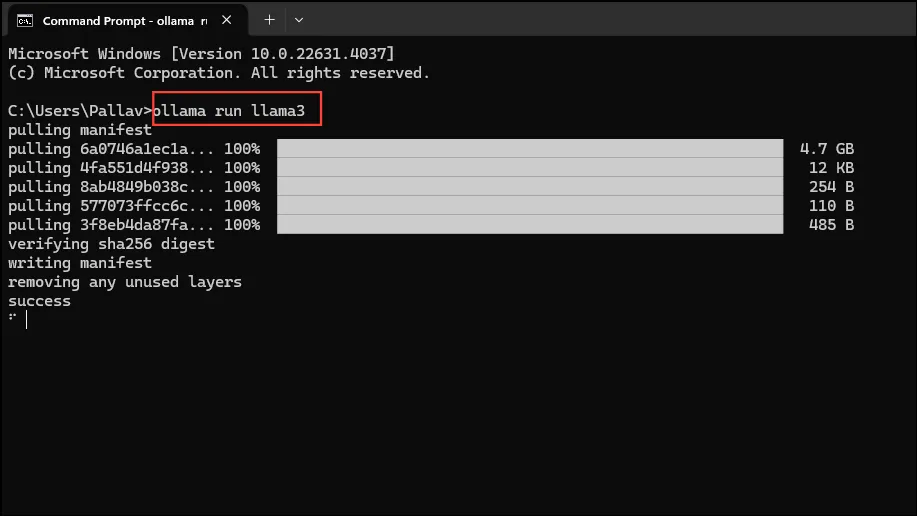

- これで、Ollama を使い始める準備が整いました。Meta の最新のオープンソース AI モデルである Llama 3 8B を使ってこれを実行できます。モデルを実行するには、[スタート] メニューからコマンド プロンプト、Powershell、または Windows ターミナル ウィンドウを起動します。

- コマンドプロンプトウィンドウが開いたら、入力し

ollama run llama3て Enter キーを押します。モデルは 5 GB 近くあるため、ダウンロードには時間がかかります。

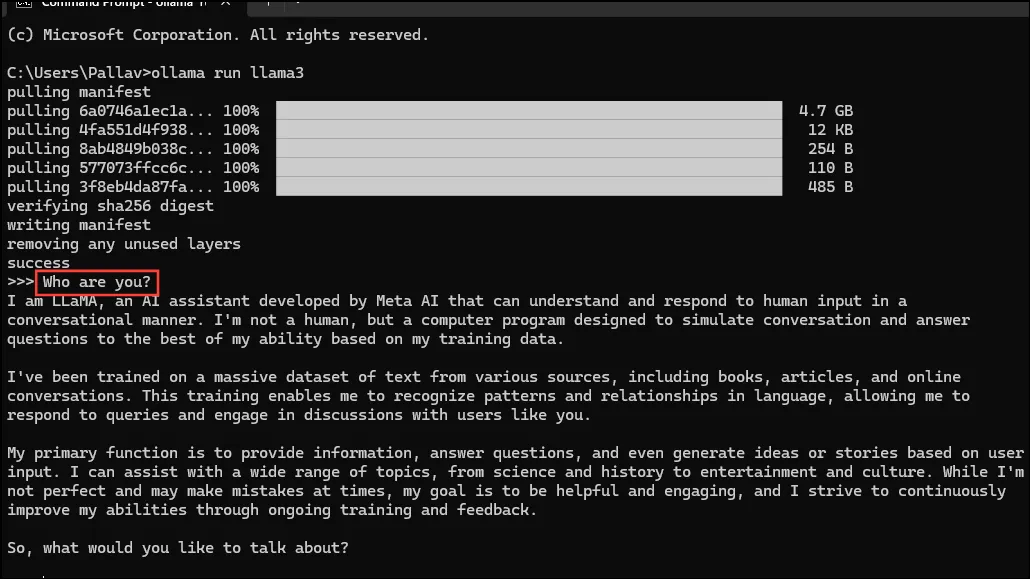

- ダウンロードが完了すると、Llama 3 8B の使用を開始し、コマンド ライン ウィンドウで直接対話することができます。たとえば、モデルに質問して

Who are you?Enter キーを押すと、応答が得られます。

- これで、会話を続け、さまざまなトピックについて AI モデルに質問することができます。ただし、Llama 3 は間違いを犯したり幻覚を起こしたりする可能性があるため、使用時には注意が必要です。

- Ollama モデル ライブラリ ページにアクセスして、他のモデルを試すこともできます。さらに、Ollama が提供するさまざまな機能を試すために実行できるさまざまなコマンドがあります。

- モデルの実行中に、セッション変数の設定、モデル情報の表示、セッションの保存など、さまざまな操作を実行することもできます。

- Ollama では、マルチモーダル AI モデルを利用して画像を認識することも可能です。たとえば、LLava モデルは DALLE-3 によって生成された画像を認識できます。画像を詳細に説明できます。

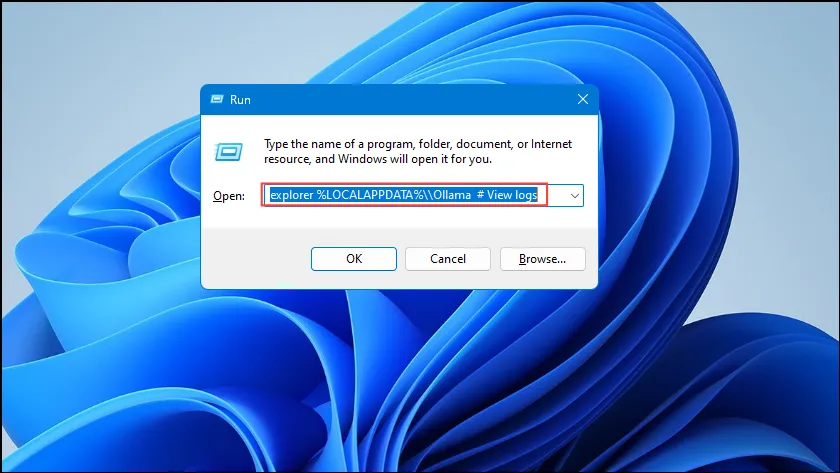

- Ollama の実行中にエラーが発生した場合は、ログを確認して問題の原因を調べることができます。

Win + Rショートカットを使用して [実行] ダイアログを開き、explorer %LOCALAPPDATA%\\Ollama # View logsその中に入力してから Enter キーを押します。

explorer %LOCALAPPDATA%\\Programs\\Ollamaやなどの他のコマンドを使用して、explorer %HOMEPATH%\\.ollamaバイナリ、モデル、および構成の保存場所を確認することもできます。

知っておくべきこと

- Ollama は AI モデルを実行するために GPU を自動的に検出しますが、複数の GPU を搭載したマシンでは間違った GPU を選択する可能性があります。これを回避するには、Nvidia コントロール パネルを開き、ディスプレイを「Nvidia GPU のみ」に設定します。

- ディスプレイ モードはすべてのマシンで使用できるわけではなく、コンピューターを外部ディスプレイに接続した場合にも表示されません。

- Windows では、タスク マネージャーを使用して Ollama が正しい GPU を使用しているかどうかを確認できます。タスク マネージャーでは GPU の使用状況が表示され、どの GPU が使用されているかがわかります。

- macOS および Linux への Ollama のインストールは Windows とは少し異なりますが、それを介して LLM を実行するプロセスはほぼ同じです。

コメントを残す