OpenAI は最近、2022 年に初めてリリースされた有名な AI 搭載チャットボット ChatGPT を動かすエンジンの新しいフラッグシップ モデルである GPT-4o モデルを発表しました。この新しいモデルは、人間とコンピューターのやり取りをより高速かつ自然にすることで、まったく新しいレベルに引き上げます。

GPT-4o では、テキスト、画像、音声を 1 つのモデルに統合しているため、「o」は「omni」の略です。GPT-4 Turbo モデルと比べて知能と推論の面では改善されていませんが、新しいアップデートが多数あります。より高速で人間らしい応答を提供するように設計されており、感情をシミュレートすることもできます。また、視覚的および音声入力の理解も大幅に高速化されています。この詳細な調査では、GPT-4o が提供する機能と、それが AI アシスタントとのやり取り方法にどのような革命をもたらすかを見ていきます。さあ、参加して、始めましょう!

GPT-4oは大幅に高速化

GPT-4o モデルにより、ChatGPT は音声、テキスト、画像、またはそれらの組み合わせなど、さまざまな形式の入力を受け入れることができます。また、さまざまな形式で応答を提供することもできます。しかし、最も印象的なのは、応答を提供する速度です。

新しいモデルでは、ChatGPT は音声入力に応答するのに約 320 ミリ秒かそれ以下しかかかりません。これは、人が会話で応答するのにかかる時間に近いです。これに加えて、英語の使用やコードの記述に関する限り、GPT-4o のパフォーマンスは GPT-4 Turbo と同様です。

また、英語以外の言語でのテキストベースの入力に応答する際のパフォーマンスも大幅に向上し、以前のバージョンよりもはるかに効率的であるため、API のコストも大幅に削減されています。

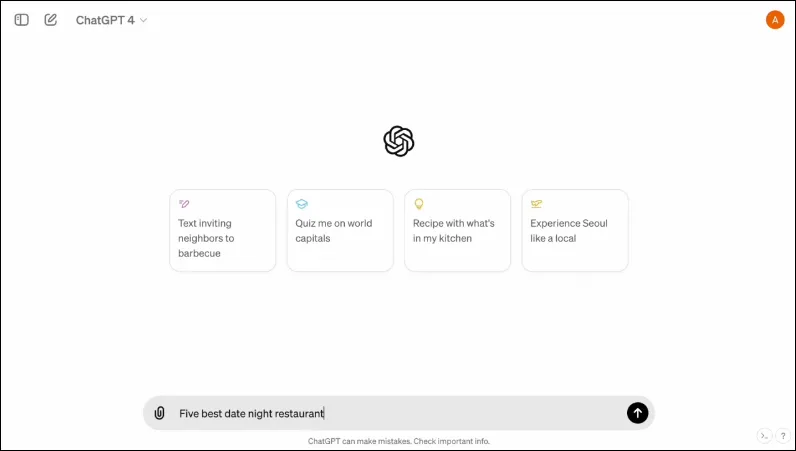

また、操作がより簡単かつわかりやすくなるように設計された新しいインターフェースも備えています。

マルチモーダルです

ChatGPT の既存の音声モードは 3 つのモデルで構成されています。最初のモデルはテキストベースの入力を受け取り、同じ形式で出力します。2 番目のモデルはオーディオ入力をテキストに変換し、それを ChatGPT が受け取り、テキストベースの出力を提供します。最後のモデルはテキストをオーディオに変換します。

しかし、この設計では、モデルがオーディオ入力と直接やり取りしたり、感情的な要素を含む出力を提示したりできないため、情報が失われます。OpenAI は、GPT-4o を使用して、さまざまな種類の入力を理解し、必要な出力を直接処理できる単一のマルチモーダル モデルを構築しました。

現在 50 の言語をサポートしており、API としても利用可能になります。

人間の感情をシミュレートできる

ChatGPT が初めて発表された当時、多くの人にとって AI チャットボットの最大の欠点の 1 つは、感情的な応答を提供できないことでした。GPT-4o を使用すると、ChatGPT は人間の感情をシミュレートし、そのような感情を統合した適切な応答を提供できます。

OpenAI が共有したデモでは、チャットボットが笑ったり、歌ったり、頼まれれば皮肉を言ったりする様子が見られます。これは、他の AI チャットボットが現在できることをはるかに上回っており、ユーザーとのやり取りがはるかに楽しくなります。OpenAI によると、新しいモデルにより、ChatGPT はユーザーの気分も検出し、その情報に基づいて適切な応答を提供できるようになります。

視覚的な入力を使用する機能と組み合わせることで、感情的な反応を提供する能力は、新しいモデルが提供する最も印象的な機能の 1 つです。

新しいモデルはより多くの情報を保存できる

GPT-4o のおかげで、ChatGPT はグラフや写真などの画像をよりよく理解できるようになり、ユーザーに関するより多くの情報を保存できるようになりました。これにより、応答に長いテキストを含めることができるようになり、さまざまなユースケースで便利になります。

たとえば、チャットボットに長いテキストを翻訳するように依頼すると、ライブ翻訳で手伝ってもらえます。テキストベースの入力だけでなく、視覚的および音声的な入力も使用できるため、スクリーンショット、写真、その他の画像から情報を収集するのに使用できます。

GPT-4o は、ユーザーが繰り返し説明する必要なく大量の情報を保存できるため、ユーザーは AI チャットボットとの会話に参加できます。情報量が増えると、会話がより洗練されたものになることが期待できます。

新しいモデルにおける安全策

既存の GPT モデルと同様に、GPT-4o は安全性を確保するために特定の安全対策を念頭に置いて設計されています。トレーニング データはフィルタリングされており、トレーニング後にモデルの動作が改良されています。OpenAI は、望ましくないインシデントを回避するために、サイバー セキュリティや説得などのいくつかのパラメーターにわたって AI モデルを評価しました。

さらに、開発者たちは、誤情報や社会心理学などさまざまな分野の 70 人以上の専門家の協力を得て、新しいモデルで発生または増加する可能性のあるリスクを特定し、軽減しました。また、将来のリスクに備えてチャットボットの使用を監視し続け、必要に応じて必要な措置を講じます。

まず、OpenAI は音声モデルのプリセットを限定的に提供します。また、ユーザーからのフィードバックも考慮してモデルを改良し、完全な安全性を確保します。

GPT-4o の可用性

これまで、ChatGPT には 2 つのバージョンがありました。GPT 3.5 で動作する無料バージョンと、GPT 4.0 で動作する月額 20 ドルの有料バージョンです。後者はより大きな言語モデルにアクセスできるため、より大量のデータを処理できます。

GPT-4o は無料ユーザーと有料ユーザーの両方が利用でき、今後数週間でデバイスに展開される予定です。既存のアプリを通じてモバイル デバイスで利用できるようになります。このアプリは更新される予定で、デスクトップ ユーザー向けの Web バージョンに加えて、新しい macOS デスクトップ アプリも利用できるようになります (Windows バージョンは今年後半にリリースされる予定です)。

無料ユーザーと有料ユーザーを区別するため、OpenAI は有料ユーザーに無料ユーザーの 5 倍の容量を提供します。制限を使い果たすと、ChatGPT 3.5 に戻ります。

OpenAI の GPT-40 に関する発表は、Google の年次 I/O 開発者会議のわずか 1 日前に行われました。この会議では、Google が独自の AI 関連の発表を行うと予想されています。OpenAI は、今後もさらなる発表を行うと約束しているため、2 つのライバル間の競争が激化し始めていることは間違いありません。

OpenAI が AI モデルへのさらなる変更をいつ発表するかはわかりませんが、GPT-4o が ChatGPT を実行しているデバイスに世界中で導入されることはわかっています。ですから、幸運を祈って、デバイスにアップデートが表示されるのを待ちましょう。それでは次回まで!

コメントを残す